百度站长平台使用教程:robots检测

我们之前的文章已经给大家分享过robots文件的作用和写法(企业网站建设提高收录的方法:编写合理的robots文件),通过robots.txt文件,我们可以直接告诉百度蜘蛛哪些页面可以被抓取,哪些页面不能被抓取。不过有时候可能由于某些疏忽,我们的robots.txt文件可能会存在一些错误,这就有可能导致网站内容不能被正常抓取。所以今天我们继续给大家分享百度站长平台使用教程,使用平台自带工具检测robots文件。

robots检测

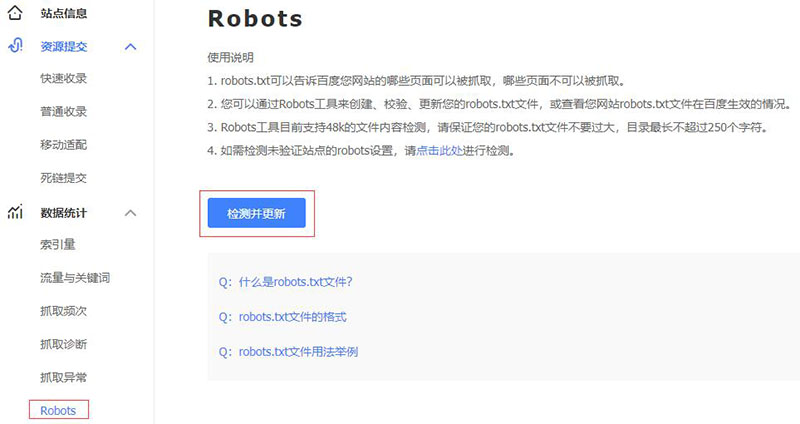

登陆百度站长平台,依次点开“数据统计”-“Robots”。该工具的使用非常简单,直接占“检测并更新”就可以显示当前网站的robots.txt文件是否正确。同时我们还可以输入网站链接去测试它是否允许百度蜘蛛抓取。

不过,最近一段时间,百度站长平台可能在进行维护调整,最近几天该工具都不能正常使用,会出现如上图这样的提示,大家可以过一段时间再来看看,或者使用其它类似的工具来代替。

总结

大多数搜索引擎蜘蛛都会遵循robots协议,即你告诉它能抓取哪些内容它就抓取哪些,所以我们一定要注意robots文件是否写正确,错误的写法会直接影响网站的收录排名。在网站上线之前大家一定要用该工具检测一下,如果目前暂时用不了,大家也可以使用第三方平台的robots检测工具(https://tools.aizhan.com/robots/)。

建站案例欣赏

网站模板

© Copyright 2024. 悦然网络工作室/悦然wordpress建站 专注中小企业wordpress建站 All Rights Reserved.网站地图

本站图片来源为Pexels、Pixabay、Freepik、Unsplash等图片库的免费许可,CC0协议;还有部分为自己手绘,版权碰瓷请自重!法律服务:law@yueranseo.com 蜀ICP备20016391号-1 川公网安备 51011502000367号